[ad_1]

Nvidia anunció hoy su nueva GPU para aprendizaje automático e inferencia en el centro de datos. Las nuevas GPU Tesla T4 (donde la 'T' representa la nueva arquitectura Turing de Nvidia) son las sucesoras del actual lote de GPU P4 que prácticamente todos los principales proveedores de computación en nube ofrecen ahora. Google, dijo Nvidia, será una de las primeras en llevar las nuevas GPU T4 a su plataforma en la nube.

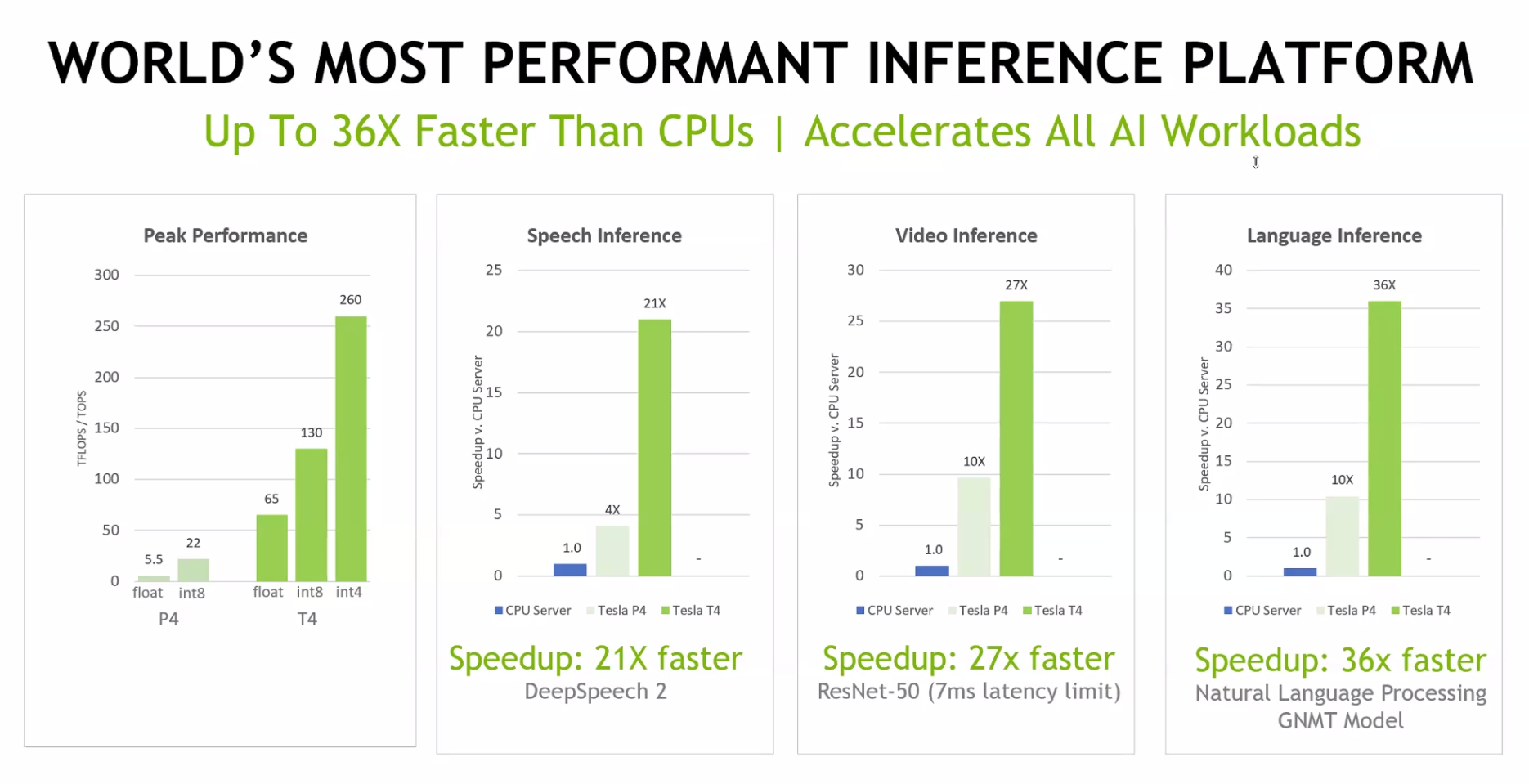

Nvidia argumenta que los T4 son significativamente más rápidos que los P4. Para la inferencia de lenguaje, por ejemplo, el T4 es 34 veces más rápido que usar una CPU y más de 3.5 veces más rápido que el P4. El rendimiento máximo para el P4 es 260 TOPS para operaciones enteras de 4 bits y 65 TOPS para operaciones de coma flotante. El T4 se encuentra en una tarjeta PCI-e de 75 vatios de bajo perfil estándar.

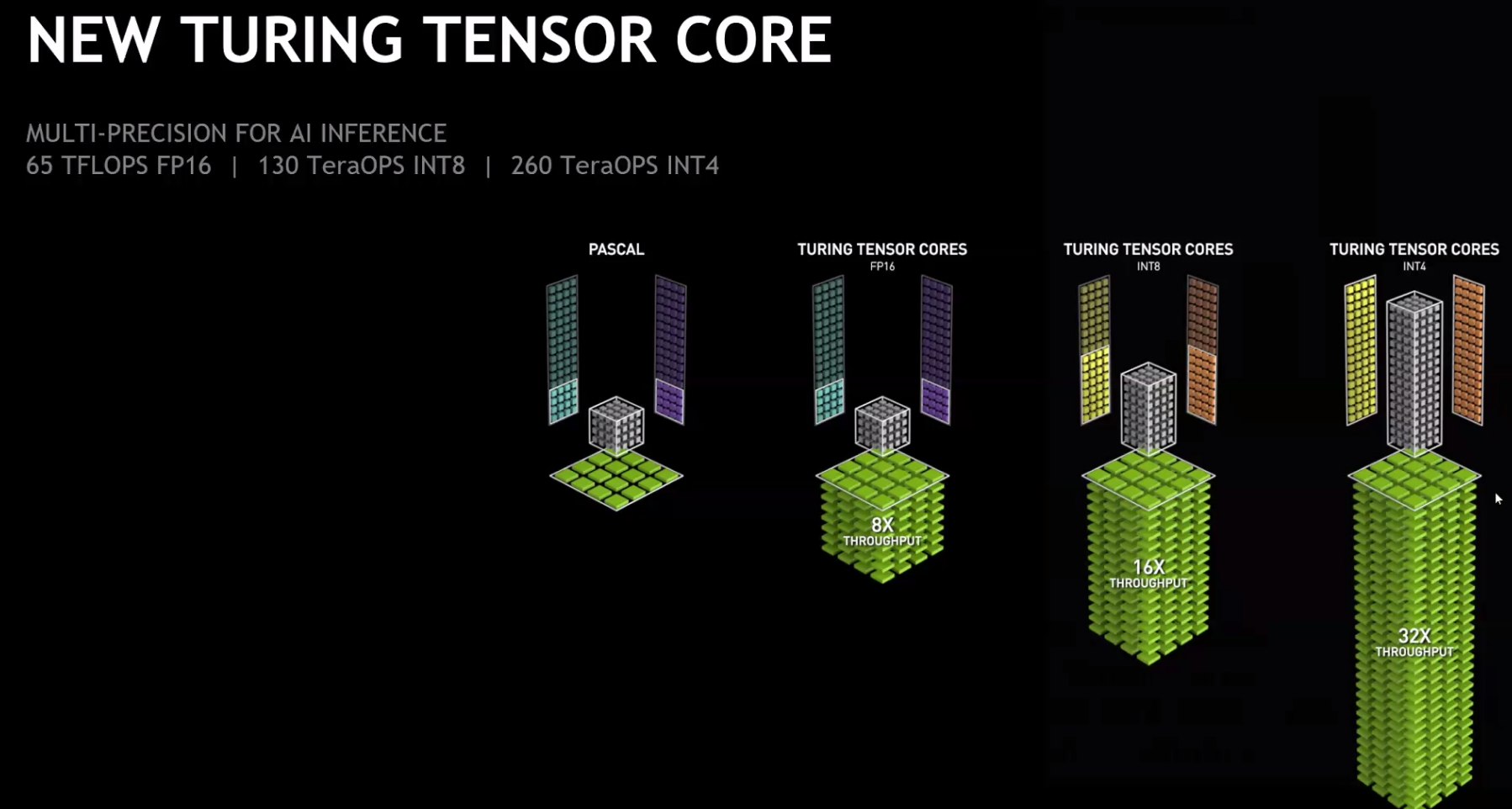

Sin embargo, lo más importante es que Nvidia diseñó estos chips específicamente para la inferencia de IA. "Lo que hace a Tesla T4 una GPU tan eficiente para inferencia es el nuevo núcleo de tensor de Turing ", dijo Ian Buck, vicepresidente y gerente general de Nvidia de su negocio de centro de datos Tesla. "[Nvidia CEO] Jensen [Huang] ya se habló sobre el núcleo Tensor y lo que puede hacer para jugar y renderizar y para AI, pero para inferencia, para eso está diseñado. "En total, el chip presenta 320 núcleos Turing Turing y 2.560 núcleos CUDA.

Además del nuevo chip, Nvidia también está lanzando una actualización de su software TensorRT para optimizar los modelos de aprendizaje profundo. Esta nueva versión también incluye el servidor de inferencia TensorRT, un microservicio totalmente contenedorizado para la inferencia de centros de datos que se conecta perfectamente a una infraestructura existente de Kubernetes.

[ad_2]

Vende Todito