Algún día tendremos una aplicación que pueda apuntar a un insecto extraño o un helecho desconocido y escupir el género y la especie. Pero en este momento los sistemas de visión artificial simplemente no están a la altura de la tarea. Para ayudar, los investigadores han reunido cientos de miles de imágenes tomadas por personas normales de bichos en situaciones de la vida real, y al estudiarlas, nuestros ayudantes de inteligencia artificial pueden ser capaces de manejar la biodiversidad.

Muchos algoritmos de visión artificial tienen ha sido entrenado en uno de varios conjuntos grandes de imágenes, que pueden tener de todo, desde personas hasta objetos domésticos y frutas y verduras en ellos. Eso es genial para aprender un poco sobre muchas cosas, pero ¿y si quieres profundizar en un tema específico o tipo de imagen? Necesitas un conjunto especial de lotes de ese tipo de imagen.

Para algunas especialidades, ya lo tenemos: FaceNet, por ejemplo, es el conjunto estándar para aprender a reconocer o replicar rostros. Pero aunque las computadoras pueden tener problemas para reconocer rostros, rara vez lo hacemos, mientras que, por otro lado, nunca recuerdo el nombre de los pájaros que caen en mi comedero en la primavera.

Afortunadamente, no soy el único con este problema, y durante años la comunidad de la aplicación iNaturalist ha estado recopilando imágenes de animales comunes y poco comunes para su identificación. Y resulta que estas imágenes son la manera perfecta de enseñarle a un sistema cómo reconocer plantas y animales en la naturaleza.

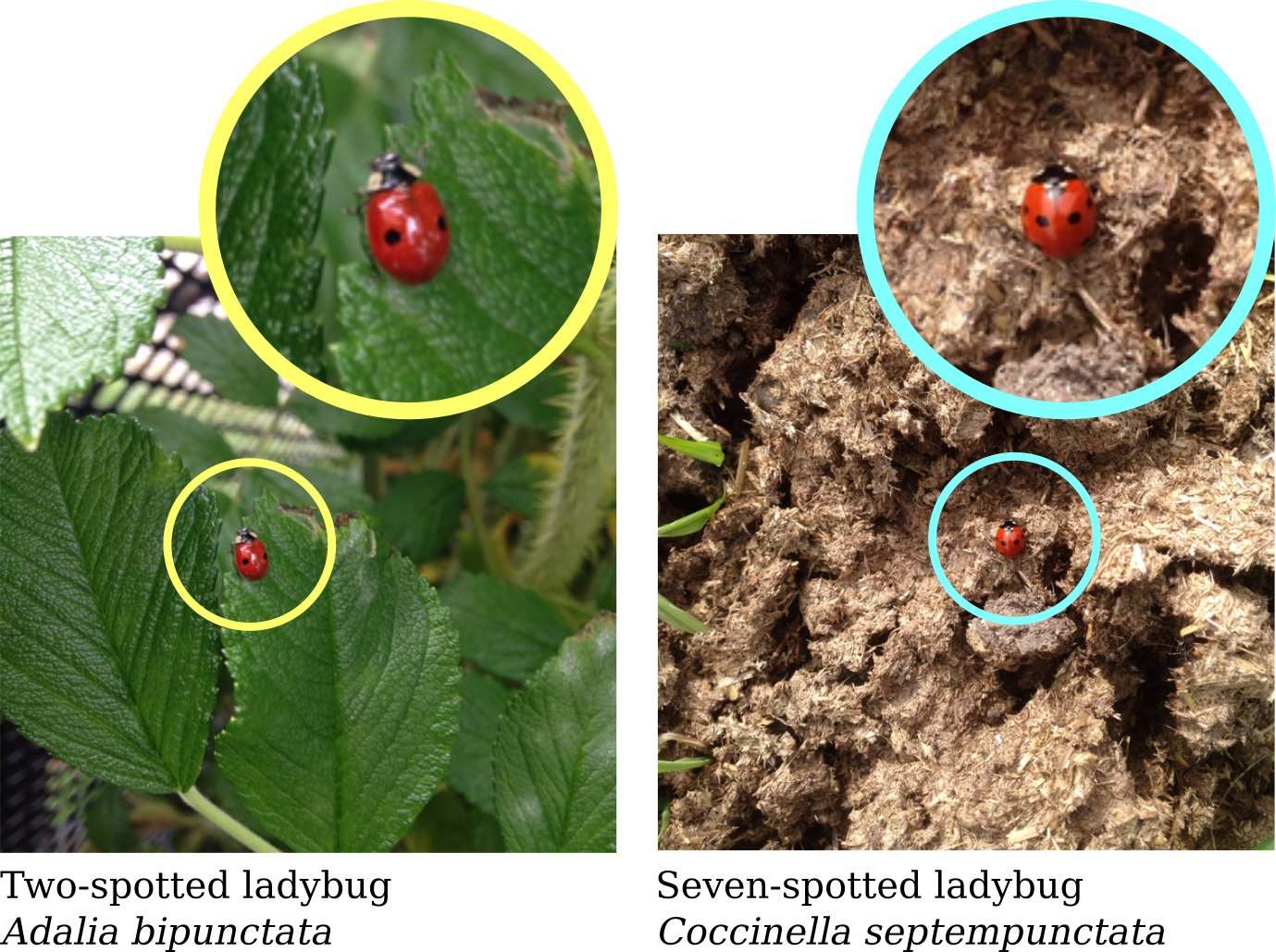

¿Podría notar la diferencia?

Podría pensar que una computadora podría aprender todo lo que necesita de libros de texto de biología, guías de campo y National Geographic. Pero cuando tú o yo tomamos una foto de un león marino, se ve muy diferente de una toma profesional: el fondo es diferente, el ángulo no es perfecto, el foco está probablemente apagado, e incluso puede haber otros animales en el Disparo. Incluso un buen algoritmo de visión por computadora podría no tener mucho en común entre los dos.

Las fotos tomadas a través de la aplicación iNaturalist, sin embargo, son del tipo amateur, pero también han sido validadas e identificadas por profesionales que, mucho mejor que ninguna computadora puede reconocer una especie incluso cuando está ocluida, mal iluminada o borrosa.

Los investigadores, de Caltech, Google, Cornell e iNaturalist en sí, reunieron un subconjunto limitado de los más de 1,6 millones imágenes en las bases de datos de la aplicación, presentadas esta semana en CVPR en Salt Lake City. Decidieron que para que el conjunto sea robusto, debería tener muchos ángulos y situaciones diferentes, por lo que buscaron especies que hayan tenido al menos 20 personas diferentes para detectarlas.

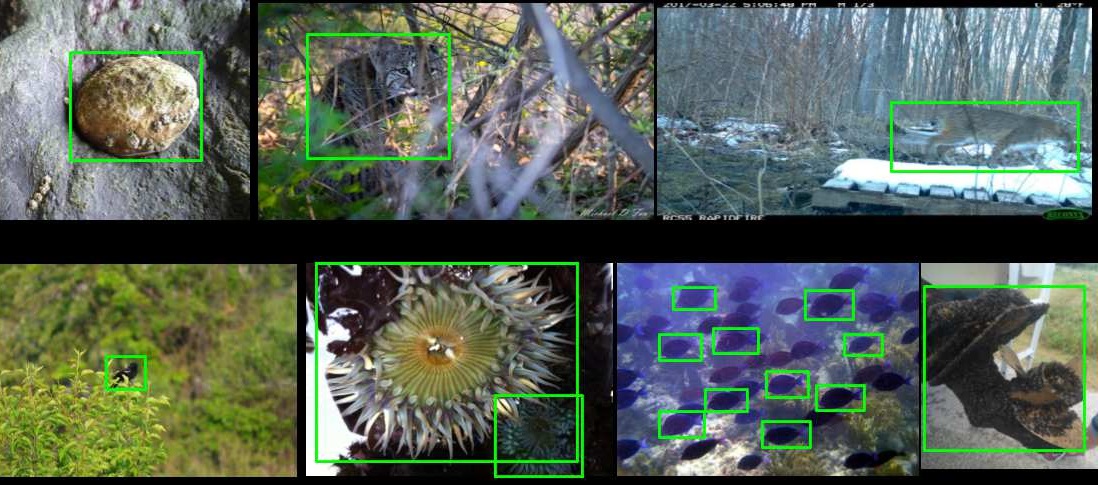

El conjunto resultante de imágenes (PDF) aún tiene más de 859,000 fotos de más de 5,000 especies. Estas personas hicieron anotaciones dibujando cajas alrededor de la criatura en la imagen, para que la computadora supiera a qué prestarle atención. Se reservó un conjunto de imágenes para entrenar el sistema, otro conjunto para probarlo.

Ejemplos de cuadros delimitadores que se colocan en imágenes.

Irónicamente, pueden decir que es un buen conjunto porque los motores de reconocimiento de imágenes existentes funcionan tan mal en él, sin siquiera alcanzar el 70 por ciento de precisión en la primera aproximación. Las mismas cualidades que hacen que las imágenes sean tan amateur y difíciles de analizar las hacen extremadamente valiosas como datos en bruto; estas imágenes no han sido desinfectadas o configuradas para facilitar la clasificación de los algoritmos.

Incluso a los sistemas creados por los investigadores con el conjunto iNat2017 no les fue tan bien. Pero está bien, encontrar dónde hay espacio para mejorar es parte de la definición del espacio problema.

El conjunto se está expandiendo, como otros lo hacen, y los investigadores observan que el número de especies con 20 observaciones independientes se ha más que duplicado desde comenzaron a trabajar en el conjunto de datos. Eso significa que iNat2018, que ya se encuentra en desarrollo, será mucho más grande y probablemente genere sistemas de reconocimiento más robustos.

El equipo dice que están trabajando para agregar más atributos al conjunto para que un sistema pueda informar no solo especie, pero sexo, etapa de vida, notas de hábitat y otros metadatos. Y si no logra identificar a la especie, podría, en el futuro, al menos adivinar el género o la clasificación taxonómica de la que confíe, por ej. es posible que no pueda decir si es anthopleura elegantissima o anthopleura xanthogrammica pero definitivamente es una anémona.

Este es solo uno de los muchos esfuerzos paralelos para mejorar la estado de la visión por computadora en entornos naturales; puede obtener más información sobre la recopilación y competencia en curso que lleva a los conjuntos de datos iNat aquí, y aquí se enumeran otros desafíos más específicos de cada clase.